AI 데이터 고갈로 붕괴되는 AI 모델

LLM의 크기가 커지고, 학습데이터가 많아지면서, 데이터 고갈 문제가 계속해서 제기되고 있죠.

가볍게 생각해 보면, 생성형 AI라는 게 데이터를 계속 만들어내는 건데, 데이터가 부족해질 일이 있나 싶기도 합니다.

생성형 AI가 만든 결과물들이 상당한 퀄리티니까, 그 결과물을 다시 재학습시키면 되지 않냐는 거죠.

한편으로는 타당한 주장으로 보입니다.

합스부르크 AI 라는 용어가 있습니다. 유럽의 대제국이었던 합스부르크 왕가가 근친혼으로 인해 무너졌다는 것을 빗댄 표현으로 AI에 합성 데이터 사용을 경계해야 한다는 표현입니다.

합스부르크 왕가의 스페인 마지막 왕 카를로스 2세는 근친혼의 부작용을 모두 가지고 있었다고 알려졌는데, 생식능력도 없었다고 하죠. 결국 합스부르크 왕가는 근친혼의 부작용 때문에 멸망한 가문으로 기록됩니다.

현재 AI 생성 데이터를 다시 AI의 학습자료로 활용하는 상황이 많이 발생하고 있습니다. 몰라서 그러는 경우도 많고, 알아도 인간이 만들어낸 데이터가 너무 부족하기 때문에 어쩔 수 없이 사용해야 되는 상황도 생기는 거죠. 요즘엔 LLM을 학습할 때 몇조 개의 토큰을 사용했다고 나오지 않습니까? 라마 4가 학습데이터로 30조 개의 토큰을 사용했다고 하네요.

The overall data mixture for training consisted of more than 30 trillion tokens, which is more than double the Llama 3 pre-training mixture and includes diverse text, image, and video datasets.

- 라마 4 공식문서 -

상황이 이렇다보니 AI가 생성한 데이터로 훈련하는 것이 문제가 없는지에 대한 연구 역시 활발히 진행 중입니다.

먼저 라마 3.1 공식문서에도 AI가 생성한 데이터로 훈련하는 건 문제가 된다고 지적했고, 옥스퍼드 대학과 케임브리지 대학등의 공동 연구로 발표한 'The Curse of Recursion(재귀의 저주)'라는 논문에서는 재귀적 학습이 데이터의 다양성과 품질을 저하시켜, 모델의 성능을 악화시키고 정보왜곡을 초래할 수 있다고 밝히기도 했습니다.

위 이미지는 네이처 기사로 데이터를 재귀적으로 훈련시켰을 때, AI 모델이 점차 붕괴되어가는 것을 나타낸 내용입니다. 데이터는 세대별로 상세 내용이 제거되면서 정보가 단순화되는 상황이 지속되어 결국 모델이 사용할 수 없을 만큼 붕괴됩니다.

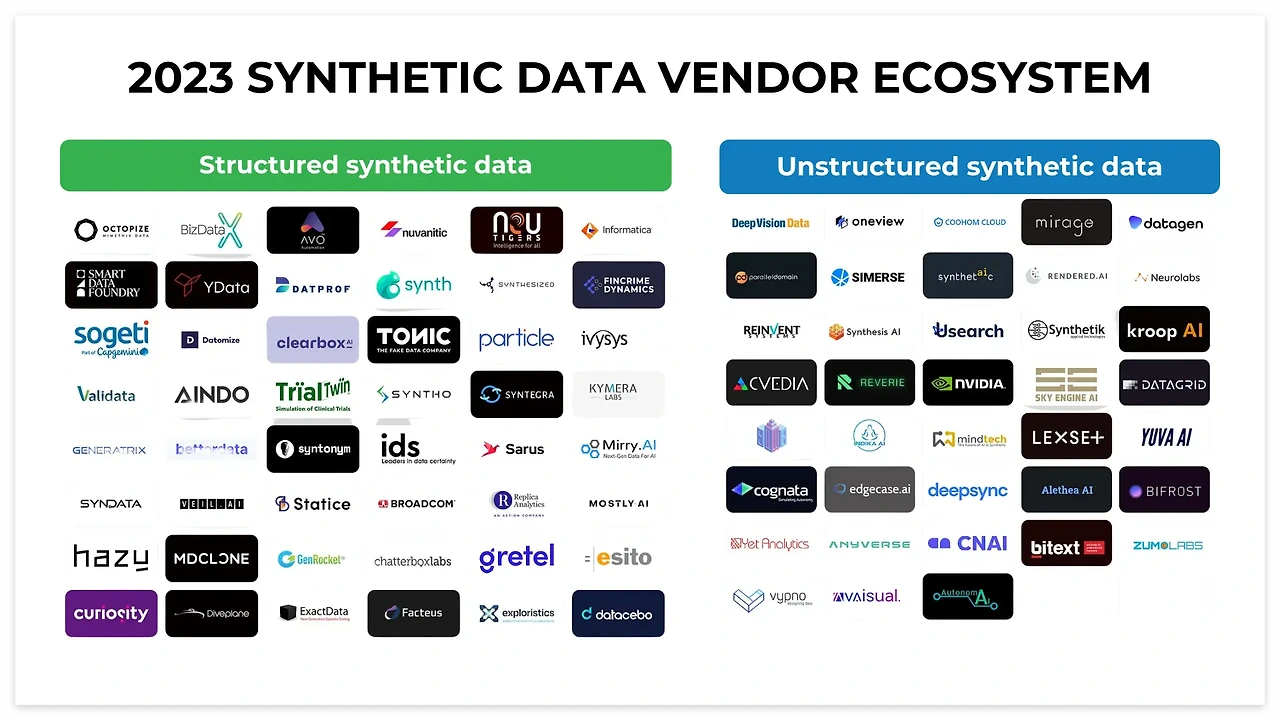

그럼 합스부르크 AI에 대한 해결책은 뭘까요?

안타깝게도 현재는 이렇다 할 해결책이 없는 상황입니다. AI로 만든 합성 데이터를 조금 더 가공해 인간들이 생성한 것과 비슷한 데이터로 만들어서 사용하는 수밖에 없죠. 이러한 기술들이 여러 회사들을 통해서 발전 중입니다. 점점 나아가는 방법을 찾기를 바랍니다.

아직 LLM의 작동원리도 파악을 못하고 있는데, 데이터가 AI에게 어떻게 적용되는가를 파악할 수 있을까요? 챗GPT가 처음 출시되고 사람들의 반응이 폭발적이었을 때, 일론 머스크를 비롯한 몇 명의 사람들이 AI 발전을 늦춰야 된다는 얘기를 했었죠. 어떻게 돌아가는지도 모르고, 제대로 검증되지도 않은 데이터를 되먹이는 현 상황을 보면 더 이상한 무언가가 나타나기 전에, 전열을 가다듬을 필요가 있어 보입니다.

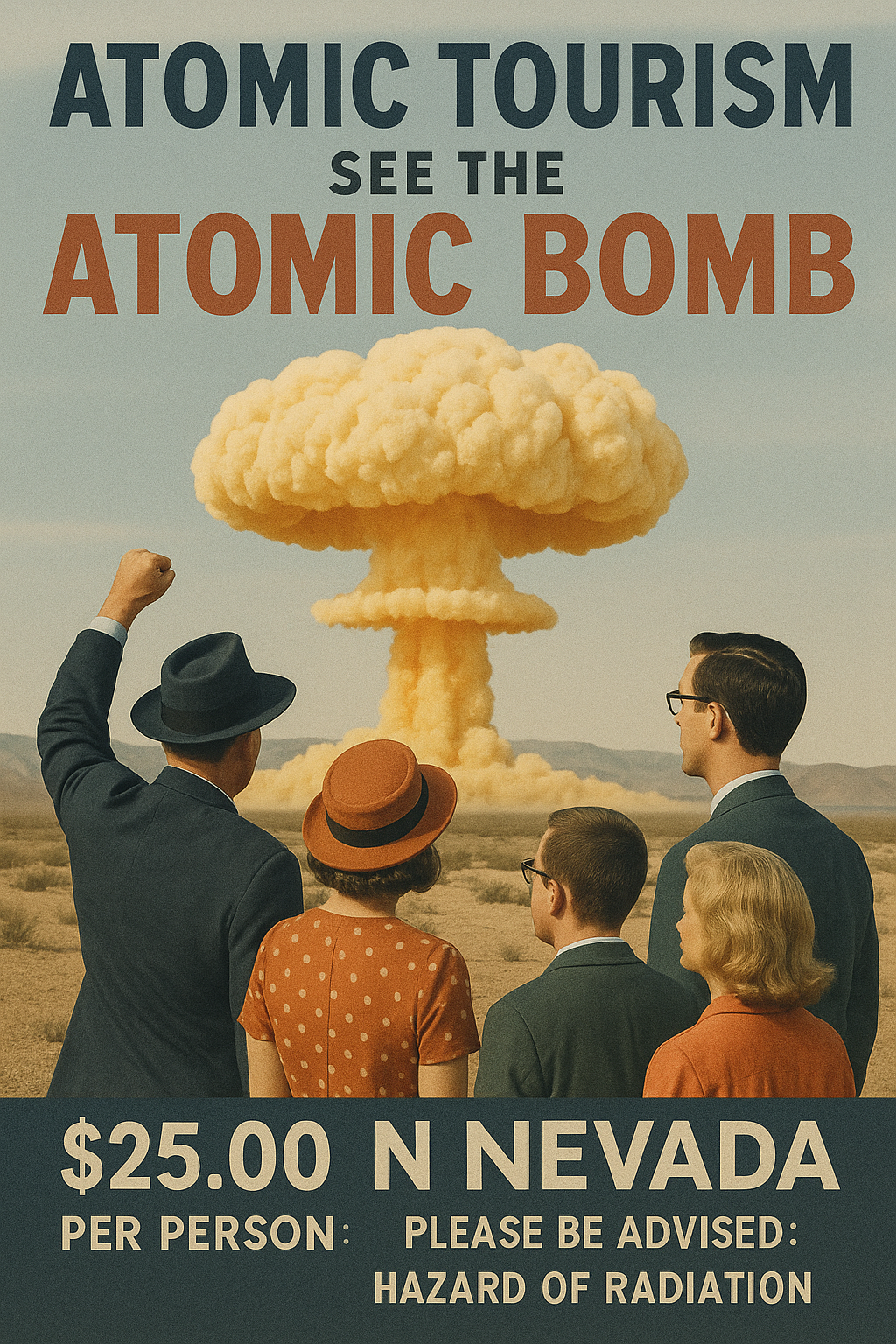

방사능의 위험이 발견되기 전 무분별한 사용으로 인해 많은 사람이 목숨을 잃었었죠. 안타깝게도 인간은 역사적으로 너무 크게 잃은 후에 깨닫는 경우가 대부분이라 걱정이 앞섭니다.

승자독식의 논리가 팽배해져 있는 지금 이 경쟁을 늦출 수 있을지 걱정스럽습니다.

인간의 실수를 몸으로 체감하지 않길 바랍니다.